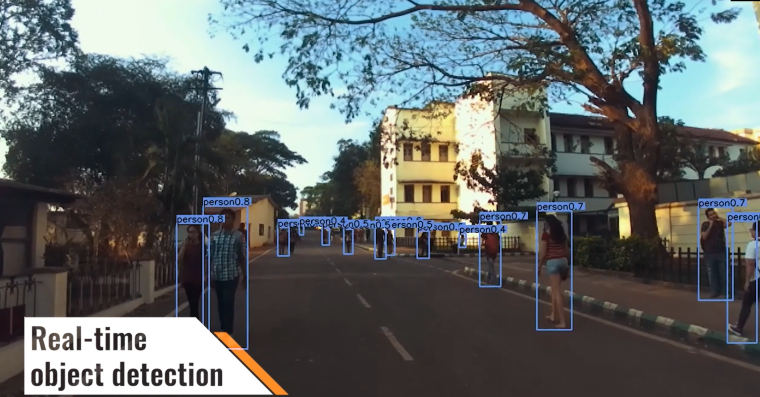

Deep Learning bringt autonomes Fahren voran

Die Zielsetzung des indischen Forschungsprojektes Manas ist die Entwicklung eines fahrerlosen Fahrzeugs, welches für die breite Bevölkerung Indiens erschwinglich ist. Für die dazu notwendige Bildgebung sorgt eine Hochgeschwindigkeitskamera.

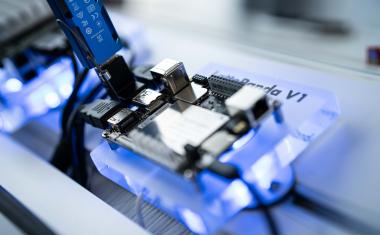

Projekt Manas, gegründet 2014, ist das offizielle KI-Robotik-Team von Mahe, einem privaten Forschungsinstitut in Manipal, Indien. Das Team gehört zu den 13 besten Teilnehmern des Mahindra’s Rise Prize, einem indischen Förder- und Innovationsprogramm. Ziel ist es, die weltweiten Grenzen der KI und der Robotik zu erweitern, indem Studierende unterschiedlicher Fachgebiete ihre Kenntnisse in einem Team kombinieren. Das primäre Ziel des Projekts Manas ist es, ein fahrerloses Fahrzeug zu entwickeln, das sich selbstständig an die indischen Straßenverhältnisse anpasst. Um dieses zu erreichen, spielt die Computer-Vision-Technologie eine wesentliche Rolle, da sie es dem Fahrzeug ermöglicht, autonom zu agieren. Die primäre Bildverarbeitungskamera dieses Projektes ist die Hochgeschwindigkeitskamera MQ042CG von Ximea, die auf dem Dach des Fahrzeugs installiert ist.

Über das Projekt Manas

Die Durchführung eines so großen Vorhabens erfordert interdisziplinäres Wissen, weshalb das Team aus Personen besteht, die auf verschiedene technische Bereiche spezialisiert sind. Die folgenden Zweige werden als Kern des Projekts betrachtet:

- Künstliche Intelligenz (KI): Die Abteilung hat die Aufgabe, den „Verstand“ des gesamten Systems aufzubauen. Das Team ist für zwei grundlegende Aufgaben zuständig: die Sammlung von Daten, die die Wahrnehmung der Fahrumgebung veranschaulichen sowie die Ableitung von Algorithmen, damit das Fahrzeug entsprechend den Fahrbedingungen Entscheidungen treffen kann. Durch diese Aufgaben ist das Team eng mit der Abteilung Sensorik und Automatisierung verflochten.

- Sensorik: Die Abteilung Sensorik beschäftigt sich mit dem Erfassen von Daten aus zahlreichen Sensoren. Das Team bereitet auch Rohdaten für die Odometrie (Schätzung von Position und Orientierung) vor und wandelt sie in kompakte Pakete für einen reibungslosen Datentransfer um.

- Automatisierung: Die Automatisierungseinheit befasst sich mit dem Empfang der verarbeiteten Befehle (Entscheidungen) von der KI und deren Weiterleitung an verschiedene Aktoren im Bot zur Navigationssteuerung. Die „Kontrolltheorie“ (Recheneinheit) wird zur Fehlerminimierung eingesetzt.

- Mechanik: Ein Roboter ist eine physische Einheit mit mechanischen Teilen, welche mit höchster Genauigkeit konstruiert und mit Präzision gefertigt werden müssen. Die Anforderungen der KI sowie der Sensorik und darüber hinaus Fertigungsbeschränkungen müssen hier berücksichtigt werden.

Die Bildverarbeitungstechnologie im Projekt

Ziel der Studierenden ist es, ein völlig autonomes Fahrzeug für die Straßen Indiens zu bauen, das sich an die unregelmäßigen und überfüllten Straßen des Landes anpassen kann. Dazu muss es in der Lage sein, außergewöhnliche und extreme Situationen selbstständig zu meistern. Der Schlüssel zum Erfolg der Studentinnen und Studenten liegt in der visuellen Verarbeitung. Dies ermöglichen die KI- und Bildverarbeitungstechnologien kombiniert mit den kompakten und schnellen Kameras von Ximea. Sie basieren auf der Kamera MQ042CG, die auf dem Dach des Fahrzeugs installiert ist. Das Projekt Manas wählte die XIQ-Kameras von Ximea aufgrund der geringen Größe (26 x 26 mm) und des geringen Gewichts (32 g).

Die Kamera MQ042CG kommt in zwei Hauptprozessen zum Einsatz: Insbesondere ist sie am Fahrzeug die primäre Bildverarbeitungsquelle des Roboters und darüber hinaus wird sie in den meisten Bildverarbeitungsalgorithmen verwendet. Diese beziehen sich auf Deep-Learning-basierte (DL) Algorithmen:

als Input für Center-net, einen DL-basierten Algorithmus, der zur Erkennung von Hindernissen verwendet wird;

als Input für Lane-net, einen weiteren DL-basierten Algorithmus, der zur Erkennung von Fahrspuren verwendet wird.

Das Team verwendete die Kameras zusammen mit dem 8-mm-Weitwinkelobjektiv LMHC8, um Bilder und Videos aus dem Fahrzeug mit einem Sichtfeld (FOV) von bis zu 78,9° in der Horizontalen aufzunehmen. Die Kamera wurde über einen Robot Operating System (ROS) Wrapper für die bestehende einheitliche API von Ximea mit dem Navigationsstapel des Fahrzeugs verbunden.

Alle Kamerabilder aus dem Wrapper werden zu einem ROS-Thema übermittelt, von dem aus mehrere Module je nach Bedarf dasselbe anfordern können. Das Bildformat wird dem ROS-Wrapper vor dem Start als Parameter angegeben. Zusammen mit den Bildern werden die Kamerainformationen wie Header und Zeitstempel synchron übertragen. Um die Kamera zu kalibrieren, nutzte das Team einen vorhandenen ROS-Perception-Kamerakalibrierungsknoten und importierte alle intrinsischen Parameter über einen internen Serviceanruf direkt in den Kameratreiber. Die Bilder werden dann von zwei verschiedenen Modulen des Fahrzeugs angefordert – Centrenet und Lanenet. Beide Module verarbeiten diese Bilder dann je nach Bedarf über ihre eigenen ROS-Wrapper.

Mit der implementierten Bildverarbeitungstechnologie erreichte das Team den ersten Eve-Prototypentest, der folgende Stufen beinhaltet: Der Autopilot ist bereit, die Kontrolle über das Fahrzeug zu übernehmen, folgt Wegpunkten, reagiert auf Verkehrssignale und Geschwindigkeitsbegrenzungen, ist in der Lage, auf Notfallverhalten zu reagieren und hat eine grundlegende Interaktion mit anderen Fahrzeugen. Die Zwischenebene wird erreicht, indem das Fahrzeug in Notfällen die Kontrolle übernimmt, während des Einparkens lenkt, umleitet und sich schließlich in den Verkehr einfädelt.

Wie sieht die Zukunft aus?

Im Laufe des Jahres will das Team die Ximea-Kamera auf einem VTOL-Flugzeug als primäre und einzige Sichtquelle nutzen. Darüber hinaus ist geplant, mehrere Kameras zu beschaffen, um ein Multikamera-Stereosystem aufzubauen, das die Möglichkeit für Tiefen- und Stereosehen schafft.

Das Team beabsichtigt weiterhin, ein Stereosystem für den Heimbereich zu entwickeln, bei dem mehrere Ximea-Kameras zum Einsatz kommen. Bei der Anbindung dieser Kameras an die Software des Fahrzeugs werden sie einen ähnlichen Ansatz verfolgen, da der aktuelle Wrapper einen Aufbau mit mehreren Kameras unterstützt. Darüber hinaus will das Team die von verschiedenen Kameras gewonnenen Bilder für das Erstellen von „Deep maps“ verwenden, die bei der Entwicklung genauerer Algorithmen für das Fahrzeug helfen sollen.

Zusammenfassung

Eine Prognose der genauen, zukünftigen Marktentwicklung von selbstfahrenden Autos fällt bei dem derzeitigen Tempo der Entwicklungen schwer. Dennoch, der rasche Fortschritt und die vielversprechenden Aussichten der Technologie deuten darauf hin, dass die allgemeine Verbreitung autonomer Fahrzeuge an Dynamik gewinnt. Durch das interdisziplinäre Team trug das Projekt zum aktuellen Ingenieurwissen für autonome Fahrsysteme bei. Der Übergang von einem teilweise vom Menschen gesteuerten zu einem vollständig autonomen Fahrzeug erfordert Systeme, die in der Lage sind, die Fahrumgebung zu überwachen und, in Übereinstimmung mit den geltenden indischen Verkehrsgesetzen, dynamisch Richtungs- und Geschwindigkeitsentscheidungen zu treffen. Die derzeitig angewandte Bildverarbeitungstechnologie verwendet visuelle Sensoren auf der Grundlage der Hochgeschwindigkeitskamera Ximea MQ042CG, die in Verbindung mit den von den Studierenden entwickelten Algorithmen das Projekt auf das Ziel der Sicherheit und Kontrollierbarkeit zusteuern. Fortschritte bei der Rechenleistung, der Netzwerkkonnektivität und eine neue Datenexplosion in Verbindung mit zahlreichen Anreizen für eine weitere Automatisierung lassen vermuten, dass es nur eine Frage der Zeit ist, bis Autopiloten die indischen Straßen in großer Zahl dominieren werden.

Meist gelesen

Dieser Roboter steht Ihnen aber gut!

Über das Phänomen der Wearable Social Robots

Supercaps: Die bessere Alternative zur Batterie?

Bei welchen Anwendungen liegen Supercaps vorn und was sind deren Vorteile?

25 Jahre Machine Vision: von Pixeln zur KI-getriebenen Zukunft

Wie Produktions- und Inspektionsprozesse von Machine-Vision-Software profitieren

SPE und Ethernet-APL: Durchbruch im Jahr 2026?

Durchgängige, leistungsfähige und zukunftssichere Kommunikation bis in die unterste Ebene der Automatisierung

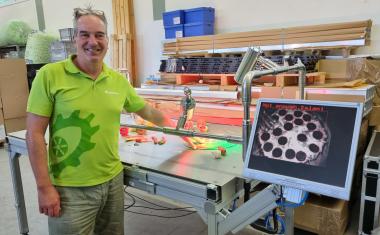

Warum Autovimation der Exaktera-Gruppe beitrat

Peter Neuhaus erläutert die Beweggründe für den Verkauf von Autovimation an Exaktera. Im Vordergrund stand die strategische Weiterentwicklung durch internationale Vertriebsstrukturen und zusätzliche Marketingressourcen.