Beleuchtung beeinflusst Deep-Learning-Anwendungen erheblich

Beleuchtung verbessert die Qualität der Bilddaten für neuronale Netze

Traditionell nutzen Bildverarbeitungssysteme regelbasierte Algorithmen, um mathematische Entscheidungen zu treffen. Doch manche Applikationen lassen sich nur schwer mathematisch abbilden, was eine Herausforderung darstellt. Viele Machine-Vision-Systeme könnten die Fähigkeit gut gebrauchen, mehrdeutige oder schwer charakterisierbare Bilder zu klassifizieren. Zum Beispiel lassen sich Bildverarbeitungsaufgaben, wie das Erkennen kosmetischer Fehler oder die finale Qualitätsprüfung eines Fertigprodukts, schwer mit statischen, traditionell programmierten Applikationen lösen. Ein Weg, solche Bildverarbeitungsanwendungen zu verbessern, besteht darin, sie mit Daten statt mit Algorithmen zu trainieren.

Um ein Deep-Learning-System umzusetzen, müssen neuronale Netzwerke – auch bekannt als CNN (Convolutional Neural Network) – mit Daten trainiert werden, die es dem System ermöglichen, mit uneindeutigen Situationen und schwierigen Charakterisierungen klarzukommen. In der Bildverarbeitung lassen sich Deep-Learning-basierte Entscheidungen nur mit Iteration optimal erzielen. Die Bilder müssen unter Fertigungsbedingungen erfasst werden – etwa in puncto Beleuchtung und Position beziehungsweise Orientierung des Objekts. Oft bedürfen solche Systeme einer großen Menge an Musterbildern, um die Variantenvielfalt zu erfassen und möglichst korrekte Ergebnisse mit möglichst wenige falsch-negative zu liefern.

Kosmetische Fehlererkennung erfordert beispielsweise, dass viele Bilder des Objekts eingegeben und als „gut“ oder „schlecht“ markiert werden. Diese Trainingsbilder müssen verschiedene Orientierungen, Licht- und Größenverhältnisse, Toleranzen, Fehler und Mängel aufweisen. Kurz: Sie müssen so viele Varianten abbilden, wie im reellen Betrieb vorkommen würden.

Es kann eine Herausforderung sein, alle möglichen Varianten, Fehler und Beleuchtungsprofile im Vorfeld zu kennen, um sie entsprechend mit Musterbildern einzutrainieren. Die Klassifizierung entspricht der Bestimmung der sogenannten „Ground Truth“, also des Feldvergleichs für gute oder schlechte Produkte beziehungsweise der Bestimmung der vorhandenen Mängel bei mehrfacher Klassifizierung.

Mit Labels werden Mängel lokalisiert oder weitere für das Training des neuronalen Netzwerks relevante Produktmerkmale erfasst. Nach dem Training und der Entwicklung müssen Deep-Learning-basierte Bildverarbeitungssysteme statistisch getestet werden, bevor sie in Betrieb genommen werden. Genauso wie manuelle Prüfverfahren können Deep-Learning-Systeme nur dadurch qualifiziert werden, dass ihre Leistung mit statistisch relevanten Daten gemessen wird.

Anwendungsbeispiel: Gute vs. schlechte Beleuchtung

Deep Learning kann helfen, Schwierigkeiten bei der Bilderfassung zu kompensieren, was manche Entwickler dazu verleitet, zu glauben, dass die Qualität der Inputdaten nicht mehr so entscheidend sei wie früher, wenn sich Deep Learning schlechten Lichtverhältnissen anpassen kann. Tatsächlich aber bleibt die „Garbage in, garbage out“-Formel weiterhin valide. Je besser die Qualität der Bilddaten von Anfang an, desto besser wird das Ergebnis.

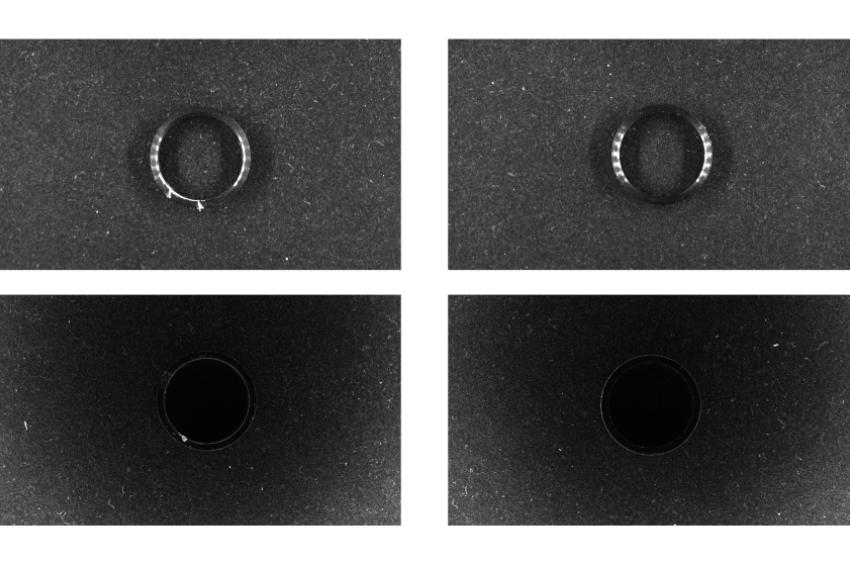

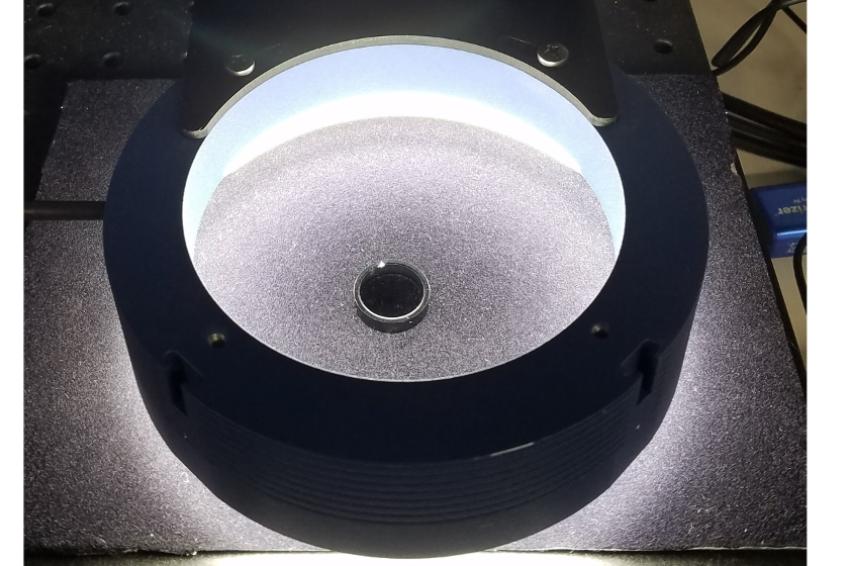

In einem konkreten Fall prüfte ein Deep-Learning-basiertes Bildverarbeitungssystem Bauteile mit guter und schlechter Beleuchtung. Ziel war es, Mängel zu erkennen und dabei die Leistung beider Leuchtkonfigurationen zu ermitteln. Die Teile wiesen einen bis drei Mängel auf, nämlich Kratzer und Dellen auf einer eloxierten Oberfläche. Zum Trainieren des Systems wurden 35 Bilder von unbeschädigten (guten) Teilen und 35 Bilder von beschädigten (schlechten) Teilen verwendet.

Die insgesamt 70 Trainingsbilder wurden sowohl mit guter als auch mit schlechter Beleuchtung erfasst und jeder Datensatz trainierte ein Klassifizierungsnetzwerk. Jedes dieser Netzwerke wurde in insgesamt 30 Epochen trainiert. Zur Datenaugmentation wurden zusätzliche Bilder generiert, indem jedes Bild vertikal und horizontal gespiegelt wurde. Dadurch verdoppelte sich jeder Datensatz auf 140 Bilder je Beleuchtungsprofil. Beide Netzwerke basierten auf derselben Trainingsmethode und Datenaugmentation, um eine gute Vergleichbarkeit zu gewährleisten.

Dieses einfache Experiment bewies, dass die Leistung einer Deep-Learning-Oberflächeninspektion deutlich besser ist, wenn die Beleuchtung optimiert wurde. Die Genauigkeit des Netzwerks, das mit gut beleuchteten Bildern trainiert wurde, war um 12,85 Prozent höher als die des Netzwerks mit schlecht beleuchteten Trainingsbildern.

Spielt die Beleuchtung also eine Rolle?

- Das Netzwerk mit guter Beleuchtung erreichte eine Trefferquote von 95,71 Prozent bei 43,21 Millisekunden durchschnittlicher Inferenzdauer.

- Das Netzwerk mit schlechter Beleuchtung erreichte eine Trefferquote von 82,86 Prozent bei 43 Millisekunden durchschnittlicher Inferenzdauer.

Deep Learning kann gute Beleuchtung also nicht ersetzen. Die Ergebnisse dieses Versuchs ließen sich auf viele Anwendungen der Bildverarbeitung übertragen. Schlechtes Licht verursacht schlechte Erkennung der Objektbeschaffenheiten und mehr Verwechslungen (falsche Treffer).

Viele gründliche Untersuchungen zeigen, dass die Genauigkeit der Klassifizierung unter Bildqualitätsproblemen wie Unschärfe oder Rauschen leidet. Zwar schneiden neuronale Netzwerke in der Regel so gut wie beziehungsweise besser als Menschen bei guter Bildqualität ab, aber deren Leistung ist viel schlechter bei schlechten Bildern. Eine gute Beleuchtung verbessert die Qualität der Inputdaten und somit auch die Fähigkeit von Deep Learning, in Machine-Vision-Anwendungen Bilder zu vergleichen und zu klassifizieren. „Smart Lighting“ – Geometrie, Struktur, Wellenlänge, Filter, etc. – bleibt sowohl für klassische als auch für Deep-Learning-Bildverarbeitungssysteme weiterhin entscheidend, um die bestmöglichen Ergebnisse zu erreichen.

| Phase 1 – Prototyp bauen | Phase 2 – Bilddaten sammeln |

|

Aktuellen Prozess analysieren und bestimmen, ob KI-/Deep-/Machine-Learning Software die richtige Lösung ist. Schritte: |

Schritte: |

| Phase 3 – Optimierung | Phase 4 – Validierung und Umsetzung |

|

KI/DL/ML-Lösung verbessern bis sie die Leistungsanforderungen hinsichtlich Falsch-Positiven/Negativen erfüllt. |

Schritte:

|

Autor

Steve Kinney, Director of Engineering

Kontakt

Smart Vision Lights

5113 Robert Hunter Drive

49441 Norton Shores, MI

001/231/722-1199

001/231/7229922