Neue Lösungsansätze durch KI Vision

Pick&Place-Aufgaben mit Roboter und Embedded-KI- Vision-Kamera intelligent automatisieren – ohne PC

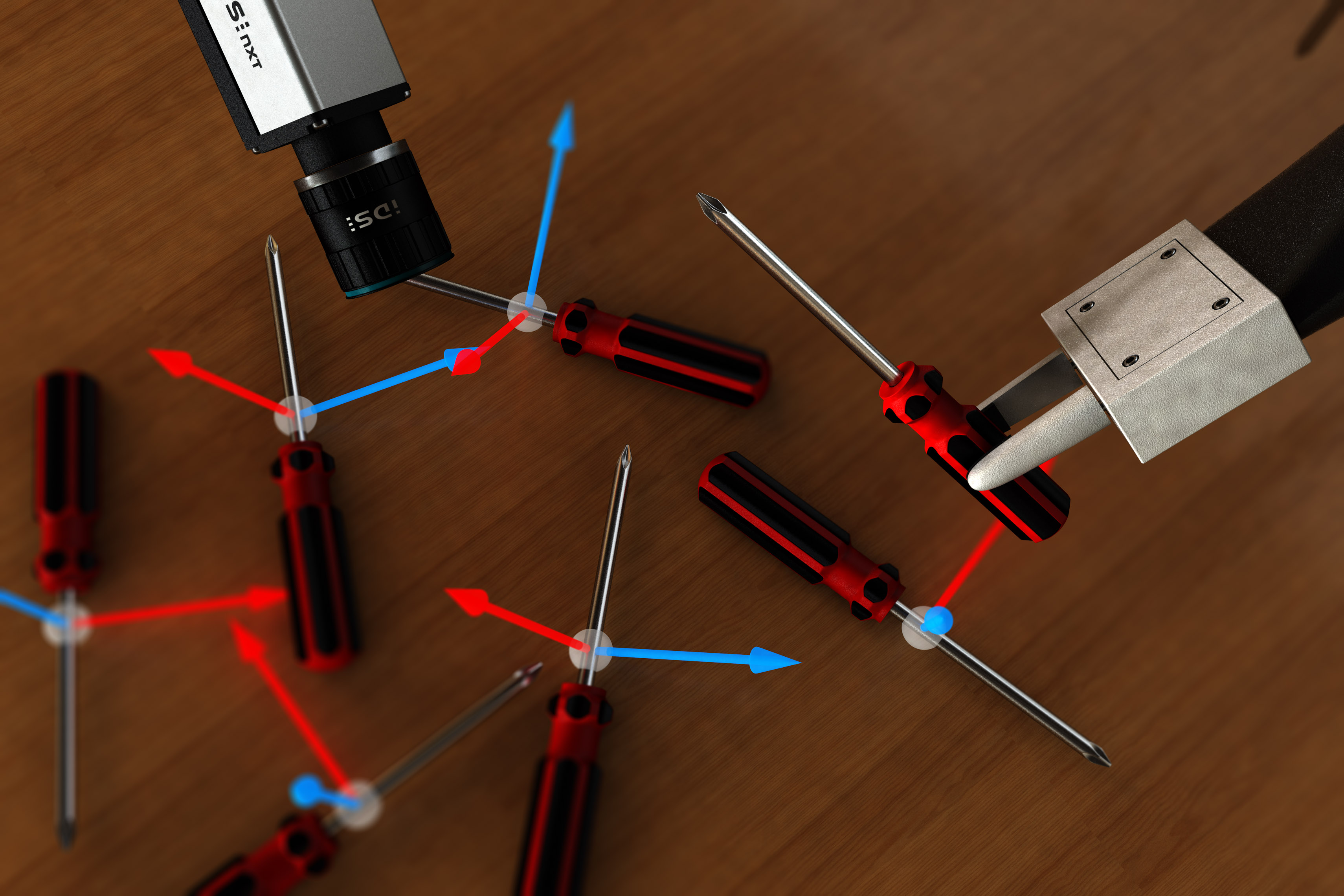

Für smartes Greifen müssen verschiedene Disziplinen optimal zusammenarbeiten. Wenn zum Beispiel Produkte unterschiedlicher Größe, Form, Material oder auch Qualität roboterbasiert sortiert werden sollen, müssen die Produkte vor dem Greifen identifiziert, analysiert und lokalisiert werden. Mit regelbasiert arbeitenden Bildverarbeitungssystemen ist das vor allem bei kleinen Losgrößen aufwendig und wirtschaftlich kaum lösbar. Doch in Kombination mit KI-basierter Inferenz können Industrierobotern heute bereits die notwendigen Fähigkeiten und das Produktwissen eines Facharbeiters antrainiert werden. Dabei genügt es, die richtigen Produkte interdisziplinär als smartes Robot-Vision-System effektiv zusammenarbeiten zu lassen.

EyeBot Use Case

In einer Fertigungslinie liegen Objekte zufällig verstreut auf einem Förderband. Diese müssen erkannt, auswählt und zum Beispiel in Verpackungen gelegt oder für eine Verarbeitungs- bzw. Analysestation lagerichtig weitergereicht werden. Das Softwareunternehmen Urobots hat für die Erfassung von Objekten und zur Robotersteuerung eine PC-basierte Lösung entwickelt. Ihr trainiertes KI-Modell war in der Lage, die Position und Orientierung der Objekte in Kamerabildern zu erkennen, aus denen dann Griffkoordinaten für den Roboter ermittelt wurden. Das Ziel war nun, diese Lösung auf die KI-basierte Inferenzkamera von IDS Imaging Development Systems zu portieren. Denn für die Lösung kam es Urobots auf zwei Dinge an:

- Der Anwender soll die Möglichkeit haben, das System ohne spezielle KI-Expertise für verschiedene Anwendungsfälle selbst anzupassen. Das heißt, auch wenn sich zum Beispiel etwas in der Produktion ändert, wie die Beleuchtung, das Aussehen der Objekte oder auch wenn weitere Objekttypen eingebunden werden sollen.

- Das Gesamtsystem sollte durch direkte Kommunikation der Gerätekomponenten ohne PC arbeiten, um sowohl kostengünstig als auch leicht und platzsparend zu sein.

Anforderungen, die mit dem Inferenzkamerasystem NXT ocean von IDS bereits zur Verfügung stehen.

Lageerkennung und direkte Maschinenkommunikation

Ein trainiertes neuronales Netz identifiziert alle Objekte im Bild und detektiert zudem ihre Position und Orientierung. Durch die KI geht das nicht nur für feste und immer gleich aussehende Objekte, sondern auch wenn natürliche Varianz vorliegt, wie beispielsweise bei Lebensmitteln, Pflanzen oder anderen flexiblen Objekten. Daraus resultiert eine stabile Positions- und Lageerkennung der Objekte.

Urobots trainierte für den Kunden das Netz mit einer eigenen Software und Wissen und übertrug es dann auf die IDS-NXT-Kamera. Dazu musste es in ein speziell optimiertes Format übersetzt werden, das einer Art „verketteten Liste“ gleicht. Die Portierung des trainierten neuronalen Netzes für die Verwendung in der Inferenzkamera erfolgte mit dem von IDS bereitgestellten Tool IDS NXT ferry. Aus jeder Schicht des CNN-Netzwerks wird dabei ein Knotendeskriptor, der jede Schicht genau beschreibt. Am Ende entsteht eine vollständige verkettete Liste des CNN in binärer Darstellung. Der speziell für die Kamera entwickelte CNN-Beschleuniger IDS NXT ocean core auf Basis eines FPGA kann dieses universelle CNN dann optimiert ausführen.

Urobots entwickelte mit dem IDS NXT Vision App Creator eine Vision-App, die aus den Detektionsdaten des CNN dann optimale Griffpositionen für den Roboter berechnete. Doch damit war die Aufgabe noch nicht gelöst. Neben den Ergebnissen was, wo und wie gegriffen wird, musste eine direkte Kommunikation zwischen der IDS-NXT-Kamera und dem Roboter hergestellt werden. Diese Aufgabe gilt es nicht zu unterschätzen. Hier entscheidet sich oftmals, wieviel Zeit, Geld und Personal in eine Lösung investiert werden muss. Urobots implementierte ein XMLRPC-basiertes Netzwerkprotokoll in der Vision-App der Kamera, um die konkreten Arbeitsanweisungen direkt an den Roboter weiterzureichen. Die finale KI-Vision-Applikation detektiert Objekte in rund 200 ms und erreicht eine Lagegenauigkeit von ± 2 Grad.

Mit KI und ohne PC

Da die Kamera selbst Bildverarbeitungsergebnisse erzeugt und nicht nur Bilder liefert, kann auf die PC-Hardware und alle damit verbundene Infrastruktur verzichtet werden. Letztendlich reduziert das die Anschaffungs- und Instandhaltungskosten der Anlage. Wichtig ist aber oft auch, dass Prozessentscheidungen direkt vor Ort getroffen werden. Folgeprozesse können dadurch schneller und ohne Latenzen ausgeführt werden, was in manchen Fällen auch eine Erhöhung der Taktrate ermöglicht. Ein weiterer Aspekt betrifft die Entwicklungskosten. KI-Vision beziehungsweise das Trainieren eines neuronalen Netzes funktioniert anders als klassische, regelbasierte Bildverarbeitung und damit ändert sich auch die Herangehensweise und Bearbeitung von Bildverarbeitungsaufgaben. Die Qualität der Ergebnisse ist nicht länger das Produkt eines manuell entwickelten Programmcodes durch Bildverarbeitungsexperten und Anwendungsentwickler. Das heißt, wenn sich eine Anwendung KI-basiert lösen lässt, können mit IDS NXT ocean auch Kosten und Zeit der entsprechenden Experten eingespart werden, denn mit der mitgelieferten Software-Umgebung kann jede Anwendergruppe ein neuronales Netz trainieren, die dazu passende Vision-App entwerfen und auf der Kamera ausführen.

Quod erat demonstrandum

Der EyeBot Use Case hat gezeigt, wie aus einer Computer Vision eine PC-lose Embedded-KI-Vision-Anwendung werden kann. Auch die Erweiterbarkeit durch das Vision-App-basierte Konzept, die Anwendungsentwicklung für verschiedene Zielgruppen und ein durchgehender Hersteller-Support sind Vorteile des kleinen Embedded Systems. Mit EyeBot sind die Kompetenzen in einer Anwendung klar verteilt. Die Aufmerksamkeit des Anwenders kann bei seinem Produkt bleiben, während sich IDS und Urobots auf das Training und die Ausführung der KI zur Bildverarbeitung und die Steuerung des Roboters konzentrieren. Ein zusätzlicher Vorteil – durch die Ethernet-basierte Kommunikation und die offene IDS-NXT-Plattform kann die entwickelte Vision-App auch für andere Objekte, andere Robotermodelle und somit für viele weitere ähnliche Anwendungen adaptiert werden.

Autor

Heiko Seitz, Technischer Autor

© Bilder IDS