Software macht KI-Entscheidungen erklärbar

Die Qualität eines neuronalen Netzes bestimmen und verstehen

Tatsache ist, dass heute schon jeder in der Lage ist, eigene KI-basierte Bildverarbeitungsanwendungen zu entwerfen, auch ohne spezielle Kenntnisse in künstlicher Intelligenz und der ebenfalls notwendigen Anwendungsprogrammierung. Und während künstliche Intelligenz viele Arbeitsprozesse beschleunigen und Fehlerquellen minimieren kann, ermöglicht Edge Computing gleichzeitig den Verzicht auf teure Industrie-Computer und die komplexe Infrastruktur, die für eine Hochgeschwindigkeits-Bilddatenübertragung erforderlich wäre.

KI beziehungsweise maschinelles Lernen (ML) funktioniert ganz anders als die klassische, regelbasierte Bildverarbeitung. Damit ändert sich auch die Herangehensweise und Bearbeitung von Bildverarbeitungsaufgaben. Die Qualität der Ergebnisse ist nicht mehr das Produkt eines manuell entwickelten Programmcodes durch einen Bildverarbeitungsexperten, so wie das bisher der Fall war, sondern wird durch den Lernprozess der eingesetzten neuronalen Netze mit geeigneten Bilddaten bestimmt. Mit anderen Worten, die zur Prüfung relevanten Objektmerkmale werden nicht mehr durch vorab definierte Regeln vorgegeben, sondern der KI muss in einem Trainingsprozess beigebracht werden, diese selbst zu erkennen. Und je variantenreicher die Trainingsdaten, desto eher erkennen die ML-Algorithmen später im Betrieb die wirklich relevanten Merkmale. Doch was sich überall so einfach anhört, führt nur mit ausreichend Fachwissen und Erfahrung zum gewünschten Ziel.

Der Einsatz von KI erfordert andere Schlüsselkompetenzen

Ohne ein geschultes Auge für die richtigen Bilddaten werden auch hier Fehler auftreten. Das bedeutet, dass die Schlüsselkompetenzen für die Arbeit mit Machine-Learning-Methoden nicht mehr dieselben sind wie die für die regelbasierte Bildverarbeitung. Aber nicht jeder hat die Zeit oder die Manpower, sich ins Thema von Grund auf einzulesen, um neue Schlüsselkompetenzen für die Arbeit mit Machine-Learning-Methoden aufzubauen. Das ist leider das Problem mit neuen Dingen – sie lassen sich nicht direkt produktiv nutzen. Und wenn sie tatsächlich ohne viel Aufwand gute Ergebnisse liefern, die sich aber leider nicht eindeutig nachvollziehen lassen, traut man der Sache nicht.

Entscheidungen sind nur schwer nachvollziehbar

Als rational denkender Mensch möchte man wissen, wie diese KI-Vision funktioniert. Doch ohne erkennbare, nachvollziehbare Erklärungen sind Ergebnisse schwierig zu bewerten. Das Vertrauen in eine neue Technologie basiert auf den Kompetenzen und Erfahrungen, die manchmal über Jahre aufgebaut werden müssen, bevor man weiß, was eine Technologie kann, wie sie funktioniert, wie man sie einsetzt und auch wie man sie kontrolliert. Erschwerend kommt hinzu, dass die KI-Vision einem etablierten System gegenübersteht, wofür in den vergangenen Jahren mit Wissen, Dokumentation, Trainings, Hardware, Software und Entwicklungsumgebungen passende Umgebungsbedingungen geschaffen wurden. KI kommt dagegen noch sehr roh und puristisch daher, und trotz der bekannten Vorteile und der hohen erreichbaren Genauigkeit sehender KI gestaltet sich eine Diagnose im Fehlerfall oftmals schwierig. Die fehlende Einsicht in die Arbeitsweise beziehungsweise unerklärliche Ergebnisse sind die Kehrseite der Medaille, was die Verbreitung der Algorithmen hemmt.

KI-Entscheidungen sind mathematische Ergebnisse

Die Arbeitsweise von neuronalen Netzen wird deshalb fälschlicherweise oft als Blackbox wahrgenommen, deren Entscheidungen nicht nachvollziehbar sind. „Obwohl DL-Modelle zweifellos komplex sind, sind sie keine Blackboxen. Tatsächlich wäre es zutreffender, sie als Glaskästen zu bezeichnen, denn wir können buchstäblich hineinschauen und sehen, was jede Komponente tut.“ [Zitat aus „The black box metaphor in machine learning“.] Inferenz-Entscheidungen neuronaler Netze basieren zwar nicht auf klassischen nachvollziehbaren Regeln, und die komplexen Wechselwirkungen ihrer künstlichen Neuronen sind für den Menschen vielleicht nicht einfach erfassbar. Dennoch sind sie Ergebnisse eines mathematischen Systems und damit reproduzierbar und analysierbar. Es fehlen nur (noch) die richtigen Werkzeuge, die uns unterstützen. In diesem Bereich der KI ist noch viel Luft nach oben. Hier zeigt sich, wie gut die verschiedenen KI-Systeme am Markt den Anwender bei seinem Vorhaben unterstützen können.

Software macht künstliche Intelligenz erklärbar

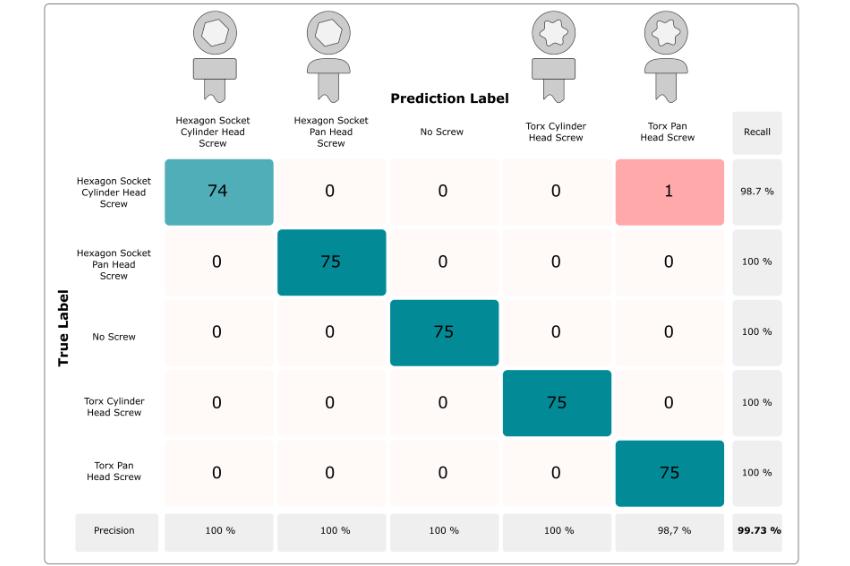

Deshalb forscht und arbeitet IDS Imaging Development auf diesem Gebiet zusammen mit Instituten und Universitäten, um genau diese Werkzeuge zu entwickeln. Das IDS NXT ocean Inferenzkamerasystem beinhaltet bereits die Ergebnisse dieser Zusammenarbeit. Statistische Analysen mit einer sogenannten Confusion Matrix ermöglichen es, die Qualität eines trainierten neuronalen Netzes zu bestimmen und zu verstehen. Nach dem Trainingsprozess lässt sich das Netz mit einer vorher festgelegten Bilderserie mit bereits bekannten Ergebnissen validieren. Dabei werden die erwarteten und die tatsächlich durch die Inferenz bestimmten Ergebnisse in einer Tabelle gegenübergestellt. Dadurch wird klar, wie oft die Testobjekte für jede trainierte Objektklasse richtig oder falsch erkannt wurden. Aus diesen Trefferraten kann dann eine Gesamtgüte des trainierten CNN angegeben werden. Darüber hinaus zeigt die Matrix deutlich, wo die Erkennungsgenauigkeit noch zu gering für den produktiven Einsatz sein könnte. Jedoch zeigt sie nicht, woran das liegt.

Heatmap zeigt Aufmerksamkeit der KI

Hier kommen die Attention Map ins Spiel, die eine Art Wärmebild zeigt, das die Bereiche beziehungsweise Bildinhalte hervorhebt, die vom neuronalen Netz die meiste Aufmerksamkeit bekommen und damit die Entscheidungen beeinflussen. Beim Trainingsprozess in IDS NXT Lighthouse wird das Erstellen dieser Visualisierungsform basierend auf den im Training erzeugten Entscheidungspfaden aktiviert, wodurch das Netz von jedem Bild bei der Analyse eine solche Heat Map erzeugen kann. Dadurch können kritische oder unerklärbare Entscheidungen der KI leichter nachvollzogen werden, um letztendlich die Akzeptanz neuronaler Netze im industriellen Umfeld zu erhöhen.

Bias erkennen und vermeiden

Ebenso lassen sich damit Datenverzerrungen, sogenannte Bias, erkennen und vermeiden, durch die ein neuronales Netz bei der Inferenz voreingenommene Entscheidungen treffen würde. Denn ein neuronales Netz wird nicht von selbst schlau. Mangelnde Qualität des Inputs führt zu mangelhaftem Output. Ein KI-System ist, um Muster zu erkennen und Vorhersagen zu treffen, auf Daten angewiesen, von denen es sein Verhalten lernt. Wenn eine KI in unter Laborbedingungen mit Daten aufgebaut wird, die nicht repräsentativ für die späteren Anwendungen sind, oder noch schlimmer, wenn die Muster in den Daten Vorurteile widerspiegeln, wird das System diese Vorurteile adaptieren.

KI auf Schwächen abklopfen

Mit solchen Software-Werkzeugen können Anwender das Verhalten und die Ergebnisse der KI-Vision direkter auf Schwächen innerhalb des Trainingsdatensatzes zurückführen und diese gezielt ausbessern. So wird die KI für jeden erklär- und nachvollziehbarer. Denn im Grunde handelt es sich nur um Mathematik und Statistik. Der Mathematik zu folgen und sie zu verstehen, ist zwar oft nicht einfach, aber mit Confusion Matrix und Heatmaps gibt es Werkzeuge, um Entscheidungen und Gründe für Entscheidungen sichtbar und damit verständlich zu machen.

Standards und Zertifizierungen erhöhen Erklärbarkeit weiter

KI-Vision richtig eingesetzt hat das Potenzial, viele Bildverarbeitungsprozesse zu verbessern. Doch die Bereitstellung von Hardware allein reicht nicht aus, um die Industrie flächendeckend mit der KI zu infizieren. Die Hersteller sind gefordert, Anwender zu unterstützen, indem sie ihre Kompetenzen in Form von benutzerfreundlicher Software und integrierten Prozessen weitergeben. Verglichen mit den bewährten Verfahren, die über Jahre gereift sind und sich mit viel Dokumentation, Wissenstransfer und vielen Software-Werkzeugen einen treuen Kundestamm aufgebaut haben, gibt es für die KI noch viel Nachholbedarf, ist aber schon im Aufbau. Auch an Standards und Zertifizierungen wird aktuell gearbeitet, um die Akzeptanz und Erklärbarkeit weiter zu steigern und die KI an den großen Tisch zu holen.

Mit IDS NXT ocean ist bereits ein KI-System mit einer umfangreichen und nutzerfreundlichen Software-Umgebung verfügbar, das jede Anwendergruppe schnell und einfach als Industriewerkzeug einsetzen kann – auch ohne tiefgehende Kenntnisse in Machine Learning, Bildverarbeitung oder Anwendungsprogrammierung.

Autor

Heiko Seitz, Technischer Autor