Was bei der Auswahl von Objektiven für Swir-Systeme zu beachten ist

11.11.2022 - Wie beeinflussen sich die einzelnen Objektivparameter gegenseitig, welche Nachteile bringt das Abblenden des Objektivs? Grundlagen anhand von Praxisbeispielen erklärt.

Wie beeinflussen sich die einzelnen Objektivparameter gegenseitig und welche Nachteile bringt das Abblenden des Objektivs? Worauf muss man bei einer geplanten Swir-Anwendungen bezüglich des Objektivs achten? Diese und weitere Fragen klärt der Artikel, ausgehend von den physikalischen Zusammenhängen und näher erläuternd anhand von Praxisbeispielen.

Mit der Einführung der künstlichen Intelligenz (KI) werden Bildverarbeitungsanwendungen immer leistungsfähiger. Mittlerweile können moderne Systeme Handschrift entziffern, ein zerknittertes Etikett erkennen oder einen Apfel von einer Orange unterscheiden. In der Lebensmittelindustrie ist es jetzt sogar möglich, über die Fähigkeiten des menschlichen Auges hinauszugehen und die oft zitierten guten Äpfel von den schlechten zu unterscheiden. Ermöglicht wird dies durch spezielle Bildverarbeitungstechnologien wie die Swir-Bildgebung, aber dazu später mehr.

Mit den neuen Möglichkeiten kommen auch neue Anforderungen an die Leistung der einzelnen Komponenten, um die bestmögliche Leistung des gesamten Bildverarbeitungssystems zu erreichen. Dazu gehört auch das Objektiv, das häufig auf der Grundlage von MTF, F/#, effektiver Brennweite (EFL) oder Verzeichnung ausgewählt wird. Jeder dieser Parameter ist wichtig für die Leistung eines optischen Systems. Das Verständnis des Zusammenspiels zwischen einigen dieser Parameter sollte jedoch bei der Optimierung eines Bildgebungssystems für maschinelle Bildverarbeitungsanwendungen von besonderer Bedeutung sein.

Physikalische Zusammenhänge der Objektivparameter

Das Gleiche gilt für die Fähigkeit, die Bewegung eines Objekts zu kompensieren, was zum Beispiel durch die Auf- und Abwärtsbewegung eines Förderbands oder durch Teile verursacht werden könnte, die zu unterschiedlichen Zeiten mit oder ohne Trays geprüft werden. Ein wichtiger optischer Parameter 2. Ordnung für dieses Szenario wäre das Erreichen einer angemessenen Schärfentiefe (DOF). Aber welche Objektivparameter beeinflussen die Schärfentiefe, und welche anderen sekundären Objektivleistungsparameter sind für Bildverarbeitungsanwendungen wichtig? Werfen wir einen Blick auf die physikalischen Zusammenhänge:

Schärfentiefe: Die Schärfentiefe (DOF) ist definiert als der Bereich zwischen dem nahen und dem fernen Objektabstand, in dem ein Objekt akzeptabel scharf abgebildet wird. Unter sonst gleichen Bedingungen hängt sie in erster Linie von F/# und EFL ab. Die nominelle Objektentfernung (Brennweite) sollte sich an einem Punkt im Raum befinden, der die Schärfentiefe für die Anwendung maximiert. Bei der unendlichen konjugierten Abbildung wird dieser Punkt als hyperfokale Entfernung bezeichnet. Bei der endlichen Abbildung hingegen liegt dieser Punkt in der Regel näher und hängt weitgehend von den Anforderungen der Anwendung ab. Bei CMOS-Sensoren ist es üblich, „Fokus“ als ein Vielfaches (zum Beispiel die zwei- oder vierfache Unschärfe) des Pixelabstands des Sensors zu definieren, je nachdem, welcher Kompromiss zwischen Schärfe und größerem DOF angestrebt wird.

In jedem Fall ist es sehr wichtig, den Begriff „Fokus“ zu definieren, bevor man darüber spricht, wie man den Schärfentiefebereich maximieren kann. Da es sich bei der EFL eines Objektivs um einen konstruktionsimmanenten Parameter erster Ordnung handelt, der bei einem Standardobjektiv nicht geändert werden kann, ist das „Abblenden“ des F/# eines Objektivs eine gängige Methode, um eine größere Schärfentiefe in einem Bild zu erzielen. Sofern das Objektiv nicht bereits beugungsbegrenzt ist, kann eine Abblendung häufig zu einer besseren MTF und einer größeren Schärfentiefe führen. Der Nachteil ist natürlich das abnehmende Gesamtlicht, weshalb es sehr hilfreich ist, wenn die Beleuchtung eine steuerbare Variable ist.

Transmission: Die Transmission ist, allgemein gesprochen, die Lichtmenge, die den Sensor erreicht. Die Leistung des gewählten IR-Sperrfilters, die AR-Vergütung, die Anzahl der optischen Elemente und die Lichtquelle wirken sich alle auf den Gesamtlichtdurchsatz aus, aber auch das F/#. Ein Objektiv mit einem höheren Öffnungsverhältnis vergrößert das Sichtfeld, verringert aber auch den Lichtdurchsatz, da ein höheres Öffnungsverhältnis zu einem kleineren Öffnungsdurchmesser führt.

Sichtfeld: Das Sichtfeld (Field of View, FOV) wird durch die effektive Brennweite (EFL) des Objektivs und den gewählten Sensor bestimmt. Bei der Optimierung für eine größere Schärfentiefe in einem Szenario, in dem die Blendenzahl nicht oder nur in einem kleinen Bereich geändert werden kann, führt ein Objektiv mit einer kleineren EFL zu einer größeren Schärfentiefe, aber auch zu einem größeren Sichtfeld (unter der Annahme eines ähnlichen Bildkreises und des gleichen CMOS-Sensors). Ein größeres FOV bedeutet auch eine geringere Vergrößerung, sodass dies bei einer Anwendung, bei der eine bestimmte Vergrößerung oder Pixel/Grad erforderlich ist, ein Kompromiss sein kann. Dementsprechend verringern sich DOF und FOV, wenn die Brennweite erhöht wird.

Relative Beleuchtungsstärke: Die relative Beleuchtungsstärke (RI) ist ein normalisierter Prozentwert, der die Beleuchtungsstärke an einem beliebigen Feldpunkt relativ zum Punkt der maximalen Beleuchtungsstärke angibt, der normalerweise auf der Achse liegt. Ein hoher RI-Wert bedeutet eine „flache“ Ausleuchtung über die gesamte Bildebene, während ein niedriger RI-Wert dunkle Ecken oder Kanten verursachen kann. Eine Erhöhung des Blendenwerts erhöht in der Regel auch den RI-Wert, was nicht mit dem Gesamtlichtdurchsatz zu verwechseln ist, der sich verringert. Eine zunehmende Verzeichnung des Objektivs kann dazu beitragen, den Kanten-RI zu erhöhen, da sie mehr realen Objektraum (Licht) in einen kleineren entsprechenden Bildraum „quetscht“. Wie viel Verzeichnung akzeptabel ist, hängt von der jeweiligen Anwendung ab. Beachten Sie, dass „Vignettierung“ und „Relative Beleuchtung“ manchmal synonym verwendet werden, aber nicht gleichbedeutend sind. Starke Vignettierung kann einen niedrigen RI verursachen, aber nicht jeder RI-Verlust ist eine Funktion der Vignettierung. RI kann mit vielen Design-Entscheidungen zusammenhängen, wird aber oft mit F/# und Verzerrungskompromissen im Design in Verbindung gebracht.

Bildfeldwölbung: Die Bildfeldwölbung ist eine Aberration, die den Grad der Krümmung der Bildebene relativ zur flachen Sensorebene definiert. Sie ist eine radial abhängige (Feldhöhe) Aberration, die sich in einer weicheren Schärfe außerhalb der Achse äußert (unter der Annahme, dass die beste Schärfe auf der Achse liegt). Dies wird häufig durch den Einsatz eines unendlich konjugierten Objektivs in einer endlichen Bildgebungsanwendung verschärft und kann sich mit abnehmender endlicher Entfernung zunehmend verschlechtern. Ein Unterschied zwischen einem Objektiv mit unendlicher und einem mit endlicher Konjugation besteht in der Art und Weise, wie es optimiert wird, um die leistungsmindernden Auswirkungen von Aberrationen zu senken.

Swir bringt viel Zusatznutzen zu geringen Kosten

Wenn man die oben beschriebenen sekundären Objektivparameter kennt, kann man für viele Anwendungen auf ein umfangreiches Portfolio von Standardobjektiven zurückgreifen und diese für einen bestimmten Anwendungsfall modifizieren. Mit der kontinuierlichen Weiterentwicklung von Technologien und Anwendungsbereichen müssen wir jedoch manchmal die Grenzen weiter hinausschieben und die Anforderungen für ein neues anwenderspezifisches Objektivdesign definieren. Die Kurzwellen-Infrarot- oder Swir-Bildgebungstechnologie ist ein solcher Fall.

Swir wurde traditionell in der Bio(medizin)-Technologie und in einigen militärischen und verteidigungsbezogenen Anwendungen eingesetzt. Angesichts des ständig wachsenden Bedarfs an Kamerasystemen für die Industrieautomation, die mehr sehen können als das menschliche Auge, und des Aufkommens kostengünstigerer Swir-Bildsensoren ist es nicht verwunderlich, dass sich Bildverarbeitungssysteme für viele neue Anwendungsfälle dem Wellenlängenspektrum jenseits des sichtbaren Bereichs (VIS) zugewandt haben.

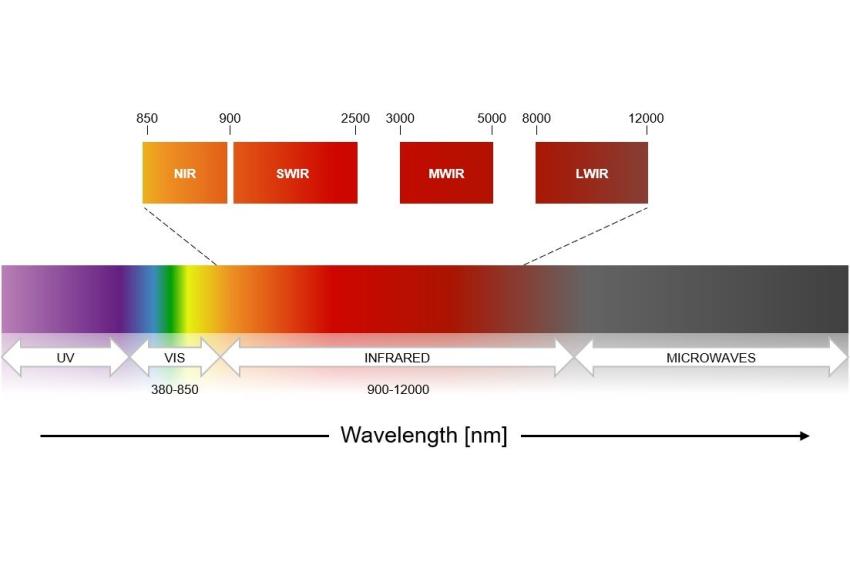

Das Infrarotspektrum von ~750 bis 12.000 nm lässt sich in zwei Kategorien unterteilen. Das „reflektierte Infrarot“ wird durch das nahe Infrarot (NIR) und das Swir-Band repräsentiert. Das „thermische Infrarot“ wird durch das mittelwellige Infrarot (MWIR) und das langwellige Infrarot (LWIR) definiert. Während die „thermischen Infrarot“-Sensoren Licht (in Form von Wärme) erkennen, das vom Objekt selbst abgestrahlt wird, erkennen die NIR- und Swir-Sensoren Photonen, die vom Objekt reflektiert werden, was eher der sichtbaren Bildgebung entspricht, mit der viele vertraut sind.

Der Bereich zwischen 900 und 2.500 nm ist von besonderem Interesse, da die von den Sternen in der Nacht ausgestrahlte Umgebungs- und Hintergrundstrahlung eine natürliche Swir-Quelle ist, die kontrastreiche Bilder ermöglicht. Wasserpartikel werden im Swir-Spektrum transparent. Eine Eigenschaft, die in der Automobilindustrie auf Interesse stößt, die sich bisher weitgehend auf Kamerasysteme im sichtbaren Spektrum verlässt, das durch Regen, Nebel oder ähnliche Wetterbedingungen beeinträchtigt wird. Zwei weitere Vorteile dieses Spektrums sind, dass die künstliche Beleuchtung relativ einfach ist, sodass der Benutzer seine eigene Beleuchtung entwerfen und steuern kann, und die Tatsache, dass ein Großteil dieses nutzbaren Spektrums immer noch von herkömmlichen optischen Gläsern abgedeckt werden kann.

Swir-Anwendungen nehmen schnell zu

Durch die kontinuierliche Weiterentwicklung von Technologien, Materialien und Herstellungsverfahren kommen Swir-Kameras heute in immer mehr Anwendungsbereichen zum Einsatz. Von der Landwirtschaft, der medizinischen Bildgebung und der Sicherheit/Überwachung bis hin zur Lebensmittelverarbeitung und nicht invasiven Qualitätskontrolle in automatisierten Produktionslinien. Einige dieser Anwendungen profitieren von der Einführung von Sensortechnologien, die gleichzeitig den sichtbaren und den Swir-Wellenlängenbereich (zum Beispiel 400 bis 1.700 nm) abbilden und eine steigende Pixelzahl (SXGA, VGA) und Auflösung (Pixelabstand von 5 µm) bieten.

Das Objektivdesign und die Fertigungsüberlegungen müssen angepasst werden, um leistungsstarke Swir-Anwendungen zu unterstützen. Die Materialauswahl für die optischen und optomechanischen Komponenten, die Form des Designs und der Optimierungsprozess müssen unter Berücksichtigung des geeigneten Wellenlängenspektrums und der Gewichtung analysiert werden. Das Erreichen der für leistungsstarke Swir-Objektive typischen hohen MTF, Ziel-F/# und geringen Aberrationen erfordert einen solchen Ansatz. Er erstreckt sich auch auf die Notwendigkeit, die optischen Beschichtungen zu optimieren, einschließlich Filter (ein- oder mehrbandig), AR- (Antireflexions-) oder BBAR- (Breitband-Antireflexions-) Beschichtungen, um die Transmission der gesamten Objektivbaugruppe zu erhöhen, wenn die Abbildung über ein breiteres Wellenlängenspektrum erfolgt (zum Beispiel VIS+NIR, VIS+Swir oder nur Swir). Das Entwicklungs Know-How und die Produktionsprozesse müssen sich ähnlich weiterentwickeln. In manchen Fällen ist die Anschaffung von neuen Testgeräten erforderlich (zum Beispiel verbesserte MTF- und Transmissionstests, um den gewünschten IR-Wellenlängenbereich, zu unterstützen) und Technologien sowie Überlegungen für Streulichttests und -minderung, Beschichtungverfahren und optomechanische Komponenten sind zu optimieren. Die genauen Leistungsparameter richten sich in der Regel nach dem Bedarf der Anwendung und umfassen die Wahl des Sensors sowie spezifische Kunden- und Endnutzeranforderungen.

Fazit

Wie so oft müssen die Gesamtsystemkosten der ersten Systeme später weiter gesenkt werden. Gelingt dies, kann dies die Verbreitung von Swir-Imaging fördern. Sich einfach auf einen neuen Sensor zu verlassen, der das sichtbare und das Swir-Spektrum abdeckt, reicht nicht aus, wenn der Rest des Systems nicht ebenfalls dazu passt ist. Das Objektiv sollte die Innovation unterstützen, wenn nicht sogar anführen, um schließlich eine breitere Anwendungsabdeckung und die Ausweitung auf neue Branchen zu ermöglichen, die sich noch gar nicht bewusst sind, dass sie dies benötigen und davon profitieren könnten.

Autor

Ingo Foldvari, Director of Business Development bei Sunex