Schnell zum Embedded-Vision-System mit Deep Learning

Trägerplatine integriert Nvdia Jetson und vier USB3-Kameras

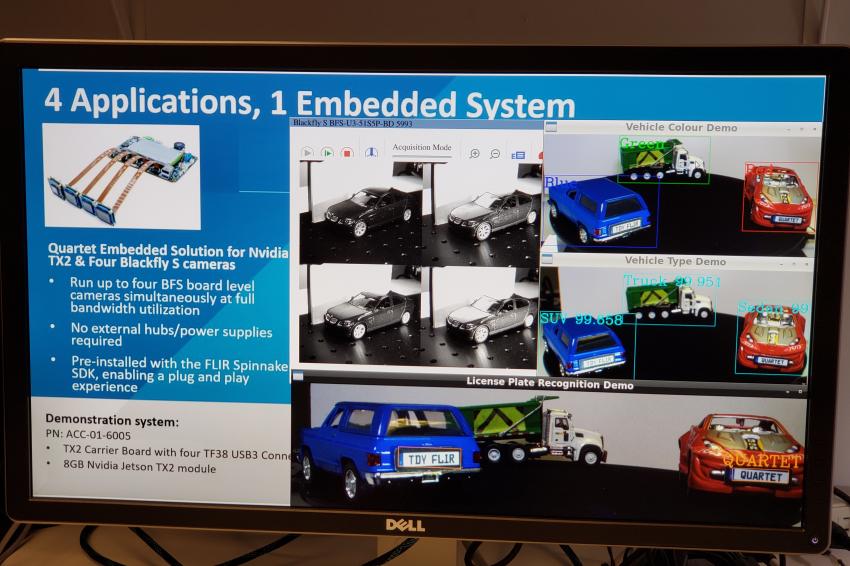

Um kompakte und zugleich leistungsfähige Embedded-Vision-Systeme zu ermöglichen und innerhalb kurzer Zeit Prototypen zu entwickeln, hat Teledyne Flir die Quartet Embedded Solution für TX2 eingeführt. Mit dieser maßgeschneiderten Trägerplatine lassen sich vier USB3-Kameras mit voller Bandbreite integrieren. Sie beinhaltet den Nvidia-Jetson-Deep-Learning-Hardwarebeschleuniger und ist im Spinnaker SDK von Flir vorintegriert. Quartet ist frisch auf dem Markt und eignet sich insbesondere für die Inspektion, mobile Robotik, Drohnen und den smarten Einzelhandel.

Dieser Praxis-orientierte Artikel beschreibt anhand von vier Anwendungsbeispielen, wie sich Prototypen entwickeln lassen. Drei davon nutzen Deep Learning:

- Anwendung 1: Kennzeichenerkennung mittels Deep Learning;

- Anwendung 2: Fahrzeugtyp-Kategorisierung mittels Deep Learning;

- Anwendung 3: Fahrzeug-Farb-

- klassifikation mittels Deep Learning;

- Anwendung 4: Frontscheibeneinblick (frei von Reflexion und Blendung).

Einkaufsliste: Hard- und Software

1. System on Module (SOM) zur Verarbeitung

Die Teledyne-Flir-Quartet-Trägerplatine für TX2 umfasst vier TF38-Anschlüsse mit dedizierten USB3-Controllern sowie ein Nvidia-Jetson-TX2-Modul. Das Spinnaker-SDK (Software Development Kit) von Teledyne Flir ist vorinstalliert und gewährleistet Plug-and-Play-Kompatibilität mit den Flir-Blackfly-S-Platinenkameras. Der Nvidia-Jetson-Deep-Learning-Hardwarebeschleuniger ermöglicht die Installation kompletter Entscheidungsfindungssysteme auf einer Platine.

2. Benötigte Kameras und Kabel

drei Standard-Flir-Blackfly-S-USB3-Platinenkameras mit den gleichen umfangreichen Funktionen wie die Gehäuseversion für die neuesten CMOS-Sensoren und eine nahtlose Integration in Quartet;

eine kundenspezifische Kamera: Blackfly-S-USB3-Platinenkamera mit dem IMX250MZR-Polarisationssensor von Sony;

Kabel: TF38-FPC-Kabel, das Strom und Daten überträgt.

3. Beleuchtung

LED-Leuchten sorgen für hinreichende Ausleuchtung, um Bewegungsunschärfe bei Nummernschildern zu vermeiden.

Anwendung 1: Kennzeichenerkennung mittels Deep Learning

- Entwicklungszeit: zwei bis drei Wochen, um das System robuster und schneller zu machen;

- Testbilder: In LPDNet enthalten.

Für die Kennzeichenerkennung kam ein handelsübliches Deep-Learning-Modell von Nvidia zur Nummernschilderkennung (LPDNet) zum Einsatz, um die Position der Nummernschilder zu erfassen. Um die Buchstaben und Ziffern zu erkennen, kam die Tesseract Open-Source-OCR-Engine zum Einsatz. Bei der Kamera handelte es sich um eine Blackfly-S-8,9-MP-Platinenfarbkamera (BFS-U3-88S6C-BD) mit Sony-IMX267-Sensor. Die Region of Interest wurde für die Kennzeichenerkennung begrenzt, um die Leistung zu beschleunigen. Stattdessen wurde Tracking verwendet, um das System robuster zu machen. Die Ausgabe enthält Begrenzungsrahmen der Kennzeichen zusammen mit den entsprechenden Nummernschildzeichen.

Anwendung 2: Fahrzeugtyp-Kategorisierung mittels Deep Learning

- Entwicklungszeit: ca. 12 Stunden, inklusive Bildaufnahme und -annotation;

- Testbilder: ca. 300.

Für die Fahrzeugtyp-Kategorisierung mittels Transferlernen haben die Teledyne-Flir-Entwickler ein eigenes Deep-Learning-Objekterkennungsmodell auf die drei verwendeten Spielzeugautos trainiert. Diese waren ein SUV, eine Limousine und ein LKW. Sie nahmen ca. 300 Testbilder des Setups aus unterschiedlichen Entfernungen und Winkeln auf. Bei der Kamera handelte es sich um eine Blackfly-S-5-MP-Platinenfarbkamera (BFS-U3-51S5C-BD) mit Sony-IMX250-Sensor. Die Entwickler annotierten etwa drei Stunden lang die Begrenzungsrahmen der Spielzeugautos. Mittels Transferlernen trainierten sie das Objekterkennungsmodell SSD MobileNet, was auf einer Nvidia-GTX1080-Ti-GPU etwa einen halben Tag dauerte. Mithilfe des GPU-Hardwarebeschleunigers kann das Jetson-TX2-Modul Deep-Learning-Inferenz effizient durchführen und Begrenzungsrahmen der Autos zusammen mit den entsprechenden Fahrzeugtypen ausgeben.

Anwendung 3: Fahrzeug-Farbklassifikation mittels Deep Learning

- Entwicklungszeit: Zum Einsatz kam dasselbe Modell wie bei der „Fahrzeugtyp-Anwendung“ mit zwei zusätzlichen Tagen für Farbklassifikation, Integration & Test;

- Testbilder: Es wurden dieselben 300 Bilder wie bei der „Fahrzeugtyp-Anwendung“ verwendet.

Zur Fahrzeug-Farbklassifikation nutzten die Entwickler dasselbe Deep-Learning-Objekterkennungsmodell wie oben, um die Autos zu erkennen, gefolgt von einer Bildanalyse anhand der Begrenzungsrahmen, um die Farbe zu klassifizieren. Die Ausgabe enthält Begrenzungsrahmen der Fahrzeuge zusammen mit den entsprechenden Nummernschildzeichen. Bei der Kamera handelte es sich um eine Blackfly-S-3-MP-Platinenfarbkamera (BFS-U3-32S4C-BD) mit Sony-IMX252-Sensor.

Anwendung 4: Frontscheibeneinblick (frei von Reflexion und Blendung)

Das Reduzieren von Blendlicht spielt bei verkehrsspezifischen Anwendungen eine bedeutende Rolle, um beispielsweise Einblick durch die Frontscheibe zu erhalten und so die Nutzung von Sonderspuren für Fahrzeuge mit hoher Besetzung (HOV-Spuren), das Einhalten der Gurtpflicht oder die Handynutzung während der Fahrt zu kontrollieren. Zu diesem Zweck haben Flir-Entwickler eine kundenspezifische Kamera entwickelt, die aus einer Blackfly-S-USB3-Platinenkamera und dem 5-MP-Polarisationsfilter IMX250MZR von Sony besteht. Diese Polarisations-Platinenkamera ist kein Standardprodukt, aber Teledyne Flir kann die Sensoren einfach austauschen, um kundenspezifische Kameraoptionen anzubieten und deren Funktion zur Blendlichtreduzierung zu demonstrieren. Die Kamerabilder wurden über die Spinview-GUI von Teledyne Flir gestreamt, die mehrere Polarisationsalgorithmus-Optionen wie Quad-Modus und Blendungsreduzierungsmodus bietet, um das verringerte Blendlicht an einem stehenden Spielzeugauto zu demonstrieren.

KI-Optimier-Tool verzehnfacht Systemleistung

Während jeder der vier Prototypen unabhängig voneinander gut funktionierte, stellten die Entwickler bei der gleichzeitigen Ausführung aller Deep-Learning-Modelle eine ziemlich mangelhafte Gesamtleistung fest. Das Tensor-RT-SDK von Nvidia bietet einen Deep-Learning-Inferenzoptimierer und eine Laufzeit der Nvidia-Hardware ähnlich dem Jetson-TX2-Modul. Also optimierten sie die Deep-Learning-Modelle mithilfe des Tensor-RT-SDK, was zu einer rund zehnfachen Leistung führte. Auf der Hardwareseite statteten sie das TX2-Modul mit einen Kühlkörper aus, um eine Überhitzung zu vermeiden, die beim gleichzeitigen Betrieb aller Anwendungen zu befürchten war. Schließlich gelang es, mit allen vier Anwendungen gleichzeitig gute Bildraten zu erzielen: 14 fps für die Fahrzeugtyp-Identifikation, 9 fps für die Fahrzeug-Farbklassifikation, 4 fps für die automatische Kennzeichenerkennung und 8 fps für die Polarisationskamera.

Autorin

Riana Sartori, Senior Manager, Machine Vision Products, Teledyne Flir