Software-Bibliothek passt sich mithilfe von Maschinellem Lernen an

Was tut ein Mensch gerade und welche Schlüsse lassen sich daraus ziehen? Dieses Erkennen und Verstehen menschlicher Handlungen ist die Hauptfunktion einer Softwarebibliothek basierend auf Maschinellem Lernen, die Forscher am Fraunhofer-Institut für Produktionstechnik und Automatisierung IPA entwickelt haben. Ihr Hauptvorteil ist ihre einfache Anpassbarkeit an neue Einsatzszenarien.

Das Erkennen und Interpretieren menschlicher Handlungen ist eine gleichermaßen komplexe wie vielversprechende Aufgabe für die Bildverarbeitung. Menschliche Handlungen sind vielfältig und bestehen oft aus mehreren kleinen Teilhandlungen, hier Aktionen genannt. Diese automatisch zu erfassen, auszuwerten und gegebenenfalls Reaktionen daraus abzuleiten, eröffnet eine Vielzahl an Einsatzmöglichkeiten: Die Arbeitsschritte eines Werkers in der manuellen Fertigung ließen sich erfassen und der Werker könnte in Echtzeit Meldungen erhalten, wenn der Prozess einen Fehler enthält, sodass er direkt und zeitsparend reagieren kann. Im Einzelhandel könnten solche Erkennungsfunktionen dabei helfen, das Verhalten der Kunden zu analysieren, um so beispielsweise die Waren bestmöglich anzubieten. Und schließlich: Könnte ein Serviceroboter, der den Menschen im Alltag unterstützt, dessen aktuelle Handlungen und Intentionen erkennen, ließen sich die Reaktionen des Roboters direkt und automatisch darauf abstimmen. Insbesondere könnte er proaktiv seine Unterstützung anbieten, ohne dass der Nutzer ihm explizite Handlungsanweisungen geben muss.

Universelle Software-Bibliothek

Am Fraunhofer IPA ist für die Umsetzung dieser Aufgabe eine neue Softwarebibliothek entstanden. Ihr Vorzug gegenüber bestehenden Systemen ist, dass sie sich einfach und ohne umfangreiche Trainingsdaten an neue Anwendungen anpassen lässt. Dabei ist sie in der Lage, nicht nur einzelne Aktionen eines Menschen zu erkennen, sondern diese als Teil einer größeren Handlung zu interpretieren und dabei zu erfassen, ob der Mensch diese korrekt ausführt. Die Software ist das Ergebnis des EU-Forschungsprojekts Socrates. Ziel des Projekts war es, Maschinen ein Verständnis menschlicher Handlungen zu geben.

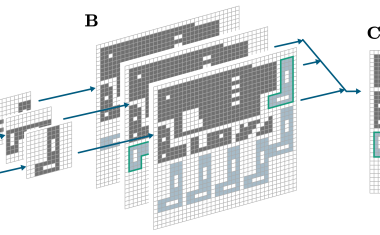

Die Software besteht aus drei Teilsystemen: einem Basismodul für die Aktionserkennung, einem Modul für das Einlernen und Erkennen anwendungsspezifischer Aktionen und dem Modul für das Erkennen von Aufgaben, also einer Abfolge von Aktionen und deren richtiger Interpretation. Die Module können – einzeln oder gemeinsam – in beliebigen Anwendungen zum Einsatz kommen. Hierfür sind jeweils nur kleinere Anpassungen nötig.

Besonderes Augenmerk haben die Entwickler darauf gerichtet, der Herausforderung der ausreichend verfügbaren Trainingsdaten für die genutzten Maschinellen Lernverfahren (ML) zu begegnen. Denn das Erschaffen und Aufbereiten der mitunter nötigen großen Datenmengen ist oft noch ein Flaschenhals für Maschinelles Lernen.

Selbstlernend auch ohne umfangreiche Trainingsdaten

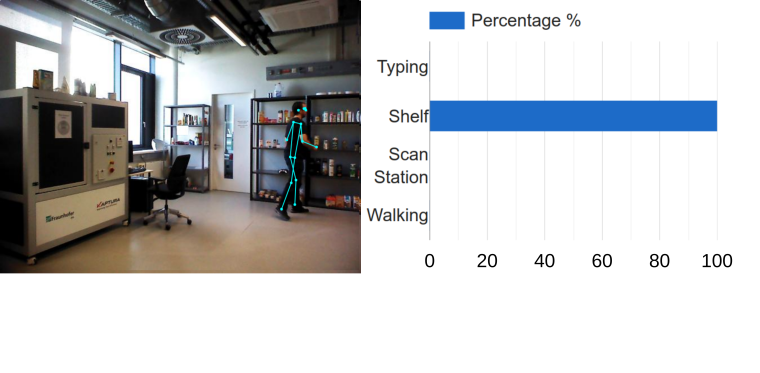

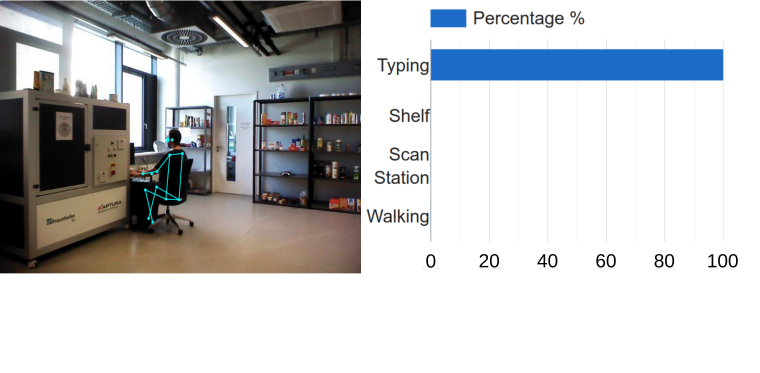

Das entwickelte Basismodul zur Aktionserkennung nutzt ein neuronales Netz („convolutional neural network“), um die aktuell ausgeführten Aktionen eines Menschen zu erkennen. Hierfür wird eine Kamera in der Einsatzumgebung installiert. Kommt eine Person in das Sichtfeld, werden zunächst ihre Gelenke in den Aufnahmen detektiert und ein virtuelles Skelett erstellt. Dafür kommt die am Markt verfügbare Software Posenet zum Einsatz. Die detektierten Skelettbewegungen werden über mehrere Bilder hinweg beobachtet und die Daten gebündelt in das neuronale Netz überführt. Dieses klassifiziert die Daten dann als Aktionen wie „hinsetzen“ oder „auf der Tastatur tippen“. Für das Training des Netzwerks kommen – wie das in vielen solcher Projekte üblich ist – öffentlich verfügbare Datensätze zum Einsatz, die die benötigten Daten in ausreichender Menge (mehrere tausend Videos der zu erkennenden Aktionen) beinhalten. Das Modul nutzt neben der genannten Software hauptsächlich Pytorch und das freie Betriebssystem für Roboter ROS.

Individualisierbares Modul für das Einlernen

In den meisten Fällen beinhalten öffentlich verfügbare Datensätze jedoch nicht genau die für eine spezifische Anwendung benötigten Aktionen. Eigene Datensätze für das Training des oben genannten Basismoduls zur Aktionserkennung anwendungsspezifisch anzulegen, wäre mit erheblichem Aufwand verbunden und ist deshalb in den meisten Fällen nicht praktikabel. Um die Methoden dennoch für den Praxiseinsatz verfügbar zu machen, hat das Fraunhofer IPA aufbauend auf dem vorhandenen Basismodul ein neues, individualisierbares Modul für das Einlernen und die nachfolgende Erkennung anwendungsspezifischer Aktionen entwickelt.

Durch den Einsatz von Clustermethoden (DBSCAN) werden dabei die Ausgaben des ersten Moduls in neue Aktionen überführt. Für das Einlernen der neuen Aktionen müssen diese nur ein paar wenige Male vor der Kamera ausgeführt werden. Dieses selbstlernende Verhalten macht die Software im Vergleich zu anderen daten- und rechenintensiven Methoden des Deep Learnings leicht trainierbar und entsprechend gut im industriellen Umfeld nutzbar. Auf technischer Seite nutzt das Modul hauptsächlich Scikit und erneut ROS.

Das dritte Softwaremodul dient dem Erkennen und der Analyse von Aufgaben, also einer Abfolge von Aktionen. Es nutzt hierfür die Ausgaben entweder des oben vorgestellten Basismoduls oder des individualisierbaren Moduls für die Aktionserkennung. Beispielsweise besteht eine Montageaufgabe aus den Aktionen „Bauteil greifen“, „schrauben“, „auf dem Tisch ablegen“. Nachdem das System diese Aktionen gelernt hat und somit erkennen kann, prüft die Aufgabenanalyse, ob die Aktionen in der richtigen Reihenfolge ausgeführt wurden. Eine frühzeitige Rückmeldung an den Werker, ob er eine Aufgabe korrekt ausführt, kann somit seine Produktivität erhöhen, weil er auf diese Weise Fehler schnell abstellen kann.

In drei Schritten einsatzbereit

Der Ablauf, um die vorgestellten drei Module für die Aufgabenanalyse zu nutzen, sieht folgendermaßen aus: Zunächst werden relevante Aktionen für die individuelle Anwendung definiert. Dann werden diese der Software beigebracht, indem sie ein paar wenige Male vor der Kamera ausgeführt und danach den automatisch vom System identifizierten Clustern geeignete Namen wie beispielsweise „Bauteil greifen“ zugewiesen werden. Dann ist die Software in der Lage, die ausgeführten Tätigkeiten eigenständig zu klassifizieren. Sie ermöglicht somit das Analysieren und Verstehen menschlicher Handlungen, ohne dass das Gesamtsystem für neue Aktionen oder Handlungen aufwendig trainiert werden müsste.

Da das Fraunhofer IPA auch abseits der vorgestellten Software umfassende Kenntnisse in der Bildverarbeitung hat, lässt sich das Anwendungsspektrum zum Beispiel mit Funktionen der Umwelterfassung bzw. Objekterkennung erweitern, um so ein noch besseres Verständnis des Menschen und seiner Interaktion mit der Arbeitsumgebung zu erreichen.

Meist gelesen

AR-gestützte Qualitätskontrolle von Kranteilen

Bauteilprüfung mit Augmented Reality direkt in der Fertigung

Laser-Distanzsensor für anspruchsvolle Oberflächen

Ein neues Sensordesign ermöglicht eine hochgenaue Messung auch bei glänzenden und strukturierten Materialien.

Effizienzsteigerung durch KI: Produktionsoptimierung und Bin Picking

Stand der KI im industriellen Umfeld

Stereo-Vision mit einer einzelnen 2D-Kamera

Ein-Sensor-Stereo-Vision für die Robotik

Alternativen zur SPS

Servoregler in Schneidemaschinen, Wickelmaschinen und Pressen